今天千问APP正式开启公测,基于阿里最强Qwen3大模型官方AI助手。

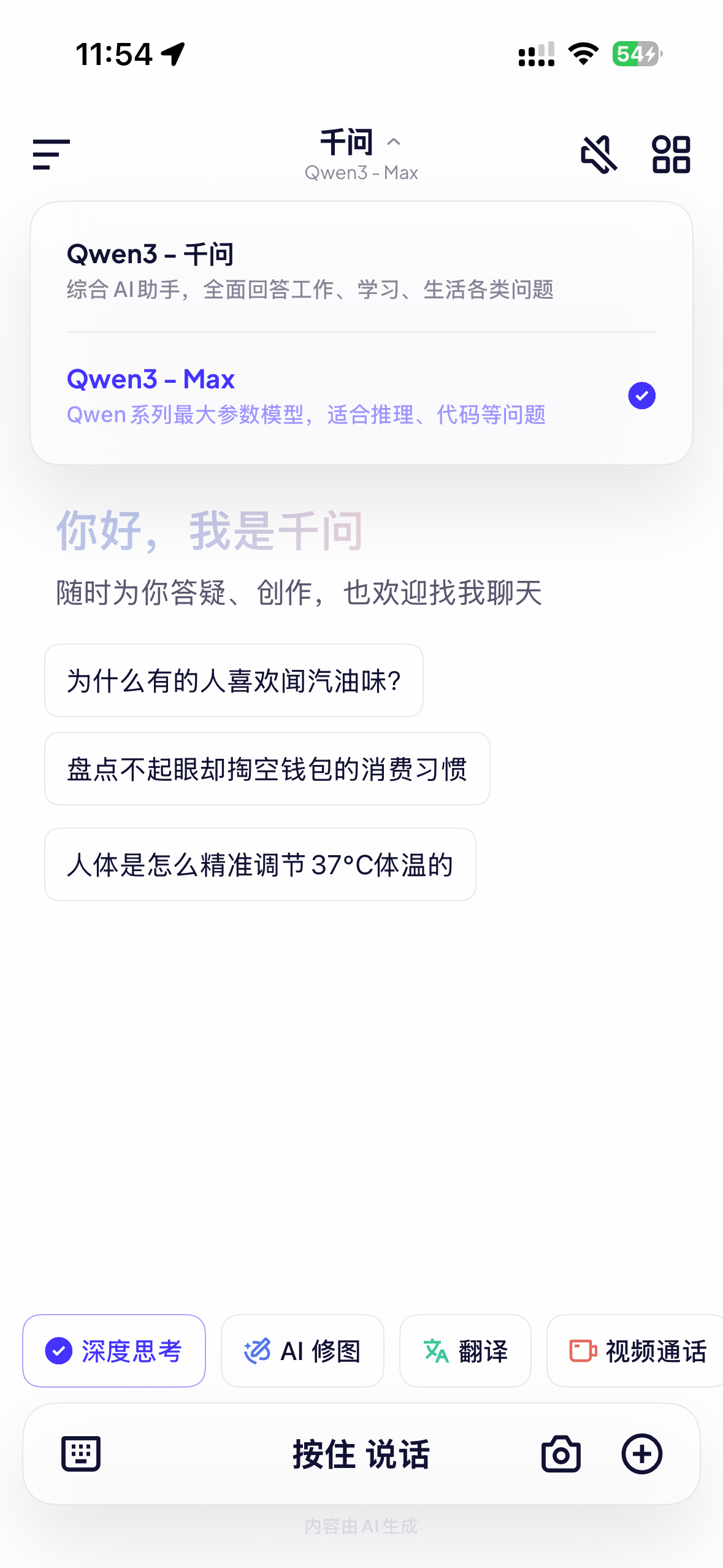

千问APP支持 Qwen3-千问和Qwen3-Max二款大模型。

Qwen3-Max是专业级解决方案,适合高要求场景;而Qwen3-千问(基础版本)是通用型助手,适合日常使用。下面详细介绍一下二个模型的差异:

一、核心区别

1. 规模与性能

- Qwen3-Max:

- 参数量超1万亿(1T+),预训练数据达36T tokens

- 在多项基准测试中全球领先:SWE-Bench Verified(代码生成)69.6分、Tau2-Bench(工具调用)74.8分、AIME25(数学推理)100分

- 支持1M长上下文,能处理整本教材或2小时视频内容

- 推理速度更快:API延迟低于800ms(1K tokens),显著优于竞品

- Qwen3-千问(基础版本):

- 参数量235B-30B(如Qwen3-235B-A22B、Qwen3-30B-A3B等)

- 性能略低于Qwen3-Max:例如Qwen3-235B-A22B在AIME25测试中得分为70.3分,而Qwen3-Max达81.6分

- 支持256K长上下文,适合处理长文档但不及Qwen3-Max

- 部署成本更低:适合资源有限的场景,本地24G显存可部署Qwen3-30B-A3B

2. 功能特点

- Qwen3-Max:

- 双模式切换:Instruct模式(快速响应)和Thinking模式(深度推理)

- 企业级可靠性:支持Function Calling、JSON Mode、流式输出,提供SLA保障

- 专业领域强化:法律、医疗、金融术语理解准确率超95%,古文解析能力强

- 工具调用能力:可自主调用外部工具解决复杂问题,如代码执行、搜索检索

- Qwen3-千问(基础版本):

- 混合推理机制:支持"快思考"与"慢思考"无缝切换,但深度不如Qwen3-Max

- 多语言支持:覆盖119种语言,中文场景表现优秀

- 基础Agent能力:能调用工具但不如Qwen3-Max精准

- 代码能力:HumanEval得分为85.3%,略低于Qwen3-Max

二、各自擅长领域

Qwen3-Max 擅长

- 复杂任务处理:如"设计高并发电商秒杀系统",能自动拆解为需求分析→架构设计→数据库选型→代码实现→压测方案

- 专业领域推理:法律、医疗、金融等领域的专业问题,术语理解准确率超95%

- 数学与代码挑战:在AIME25、HMMT等竞赛中获满分,SWE-Bench Verified测试达69.6分

- 企业级应用:金融、政务等高要求场景,支持SLA保障和阿里云百炼平台深度集成

Qwen3-千问(基础版本)擅长

- 日常对话与简单任务:快速回答常识问题,响应延迟低

- 多语言基础交流:支持119种语言,适合跨语言沟通

- 轻量级编程辅助:生成基础代码片段,适合简单开发任务

- 移动端应用:资源消耗较低,适合在手机App中部署使用

三、如何区分使用

1. 按场景选择

- 选择Qwen3-Max当:

- 需要解决复杂专业问题(如法律咨询、医疗诊断)

- 处理超长文档(如整本教材、技术白皮书)

- 开发企业级AI应用(需高可靠性、SLA保障)

- 需要深度推理能力(如数学竞赛题、复杂逻辑问题)

- 选择Qwen3-千问(基础版本)当:

- 进行日常对话交流

- 处理简单任务(如写邮件、基础编程)

- 移动端使用(资源有限的设备)

- 快速响应需求(对延迟敏感的场景)

2. 实用建议

- 在千问App中:通常基础版本(Qwen3-千问)作为默认模型提供,适合日常使用;Qwen3-Max可能需要手动切换或通过特定功能入口访问

- API调用时:Qwen3-Max需指定

model="qwen-max",而基础版本使用model="qwen-plus"或model="qwen-turbo" - 成本考量:Qwen3-Max推理成本约为基础版本的1.5-2倍,但性能提升显著

- 思考模式:Qwen3-Max的Thinking模式需启用

incremental_output=true参数才能发挥完整推理能力

四、技术架构差异

| 特性 | Qwen3-Max | Qwen3-千问(基础版本) |

|---|---|---|

| 参数量 | 超1万亿(1T+) | 30B-235B |

| 训练数据 | 36T tokens | 36T tokens |

| MoE架构 | 超大规模混合专家 | 标准混合专家 |

| 长上下文 | 支持1M tokens | 支持256K tokens |

| 推理模式 | Instruct + Thinking双模式 | 基础混合推理 |

| 部署要求 | 需要高端GPU/云服务 | 可本地部署(24G显存) |

评论区